인텔의 비전 2024 행사에서는 차세대 AI 가속기인 가우디 3(Gaudi 3)의 공개와 함께 깜짝 손님으로 한국의 네이버가 초대됐습니다. 네이버는 가우디 2를 인텔 클라우드에서 테스트해 거대 언어 모델 (LLM) 성능을 검증하고 개발했습니다. 네이버 개발팀에 따르면 가우디 2는 전력 대 성능비가 우수하고 LLM에 강점을 지닌 AI 가속 하드웨어입니다. 네이버 클라우드와 인텔은 AI 공동연구센터(NICL, NAVER Cloud·Intel·Co-Lab)를 설립하고 카이스트, 서울대, 포스텍 등 국내 대학 및 스타트업과 함께 AI 생태계 구축에 나서기로 했습니다.

다만 가우디 2가 네이버의 AI 서비스에 바로 활용되는 것은 아닙니다. 가우디는 최근에야 시장에 합류한 신참으로 이미 시장에서 견고한 위치를 차지하고 있는 엔비디아 GPU처럼 바로 서비스에 투입할 만큼 생태계가 구축되어 있지 않습니다. 여기에 엔비디아가 계속해서 차세대 GPU를 개발하면서 경쟁자를 저 멀리 따돌리려고 하고 있기 때문에 이를 추격하기 위해서는 가우디 2의 상용화보다 후속 모델 개발에 집중해야 할 형편입니다.

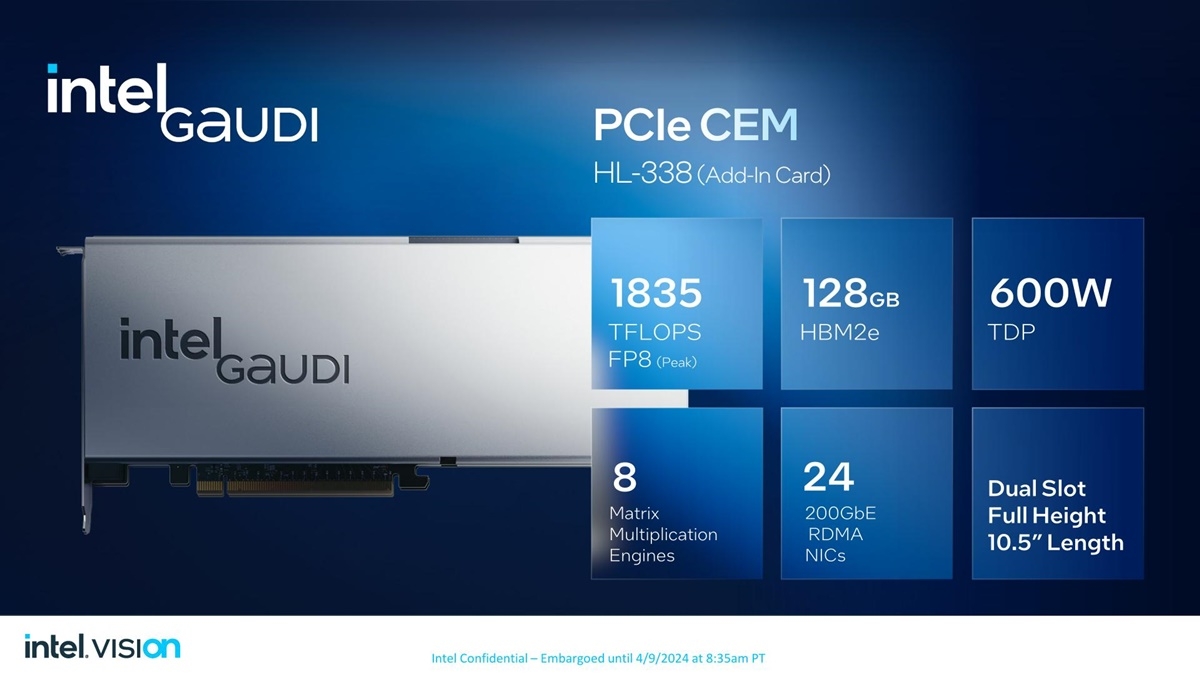

따라서 이날 행사에서 인텔은 차세대 AI 가속기인 가우디 3를 공개하고 올해 하반기에 출시한다고 발표했습니다. 가우디 3는 TSMC의 5nm 공정으로 제조되며 128GB의 HBM2e 메모리를 탑재하고 있습니다. 트랜지스터 집적도를 비롯한 더 구체적인 정보는 공개하지 않았지만, 가우디 2와 비교해서 텐서 코어를 24개에서 64개로 늘리고 연산 능력도 865 TFLOPS에서 1835 TFLOPS로 두 배 이상 대폭 늘렸다는 것이 인텔의 설명입니다.

비전 2024 행사에서 인텔은 가우디 3가 엔비디아의 H100보다 더 빠르다고 주장했습니다. 예를 들어 Llama2-13B 훈련 기준으로 1.7배 빠르고 GPT 3 – 175B에서는 1.5배 빠릅니다. 그리고 다른 AI 연산에서도 전력 대 성능비로 우위에 있다는 것이 인텔의 주장입니다. 하지만 이 주장이 맞다고 해도 인텔의 도전은 쉽지 않은 게 사실입니다. H100은 이제 출시된 지 2년이 지난 제품이고 엔비디아는 이미 그 후속작인 블랙웰 GPU를 공개했기 때문입니다.

블랙웰 B200의 AI 연산 능력은 FP 8 기준으로 4.5페타플롭스로 단순 수치만 봐도 가우디 3보다 몇 배 뛰어납니다. 여기에 AI 서비스 기업과 개발자들이 사용하기 쉬운 생태계가 이미 구축된 점은 엔비디아 AI 하드웨어의 넘볼 수 없는 장점입니다. 이런 점을 봤을 때 가우디 3가 시장에서 의미 있는 성과를 거둘 수 있을지는 아직 미지수입니다. 하지만 엔비디아의 AI 하드웨어가 공급 부족에 시달리는 점이 한 가지 변수가 될 수 있습니다. 공급난을 타개하기 위해 엔비디아 GPU 이외에 다른 대안에 눈을 돌리는 기업이 많아질 수 있기 때문입니다.

한국과 손잡은 인텔의 가우디 AI 가속기가 치열한 경쟁 속에서 자신의 입지를 확보할지, 아니면 경쟁에서 밀려나 사라질지는 아직 말하기 이릅니다. 하지만 발전 속도가 매우 빠르고 한 번 뒤처지면 따라잡기 어려운 IT 분야의 속성을 생각할 때 결론이 나오는 것은 먼 미래가 아닐 것으로 생각합니다.

고든 정 과학 칼럼니스트 jjy0501@naver.com

Copyright ⓒ 서울신문 All rights reserved. 무단 전재-재배포, AI 학습 및 활용 금지